畳み込みニューラルネットワークの基礎と応用:効果的なCNNの活用法を解説

畳み込みニューラルネットワーク(CNN)は、画像認識や自然言語処理など様々な分野で活用されています。本記事では、CNNの基礎から応用までを詳しく解説します。CNNを効果的に活用するためのポイントも紹介します。

はじめに

畳み込みニューラルネットワークの基礎と応用について解説します。

畳み込みニューラルネットワーク(CNN)は、近年、機械学習やディープラーニングの分野で注目を集めています。その特徴的な構造と高い性能から、画像認識や自然言語処理などのさまざまなタスクにおいて優れた成果を上げています。

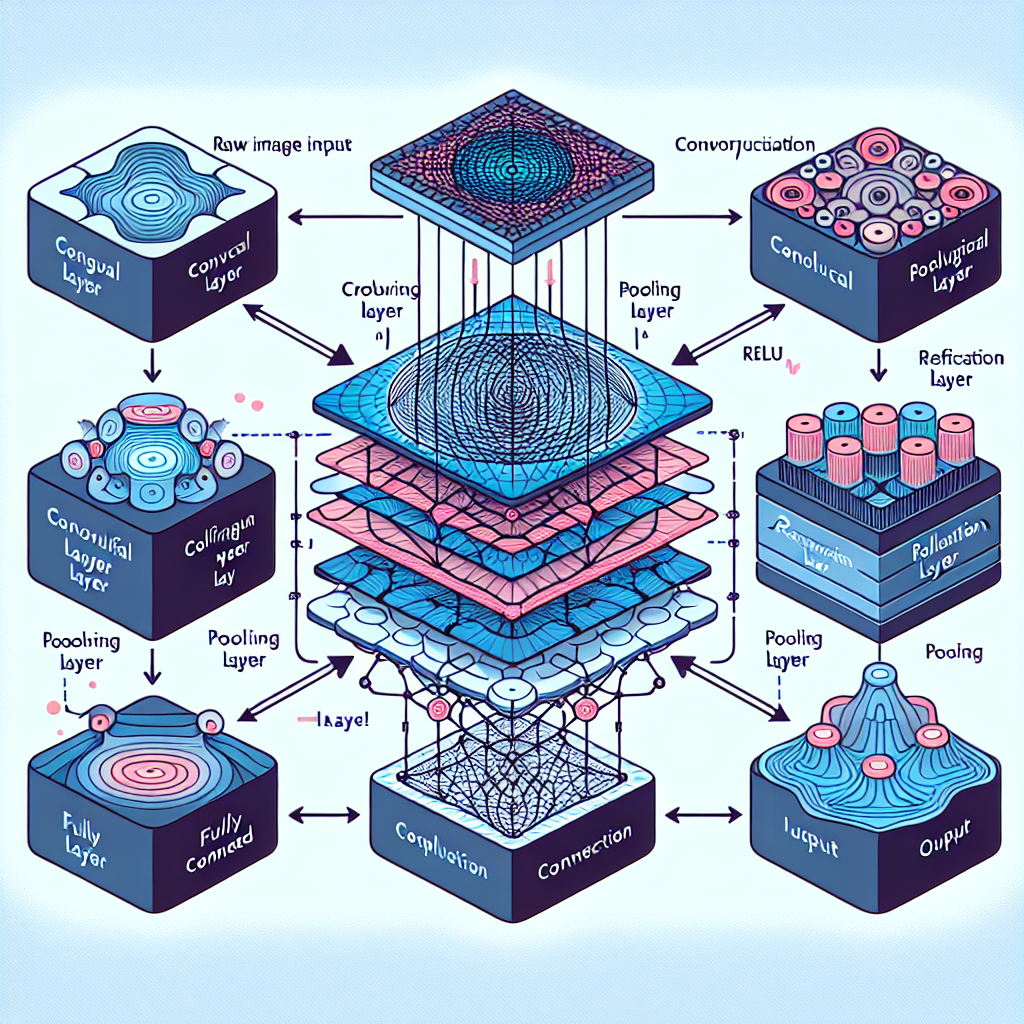

畳み込みニューラルネットワークの基礎として、畳み込みやプーリングといった操作があります。畳み込みは、画像やテキストなどの入力データから特徴を抽出するための操作であり、プーリングは特徴マップを縮小することで計算量を削減し、情報の損失を抑える役割を果たします。

さらに、活性化関数の選択や最適化アルゴリズムの適用なども重要です。活性化関数は、ニューラルネットワークの非線形性を担う要素であり、適切な活性化関数の選択がネットワークの学習に大きな影響を与えます。

畳み込みニューラルネットワークは、画像認識や自然言語処理、医用画像解析など、さまざまな分野で応用されています。これらの応用において、畳み込みニューラルネットワークは高い精度を実現し、新たな可能性を切り拓いています。

畳み込みニューラルネットワークの学習方法や評価指標、さらには転移学習の活用や最適化手法についても理解することで、より効果的にCNNを活用することができます。

この記事では、畳み込みニューラルネットワークの基礎から応用までを詳しく解説し、CNNの活用法について理解を深めていきましょう。

畳み込みニューラルネットワークの理解

畳み込みの仕組み

畳み込みとは、入力データに対してフィルターを適用して特徴マップを生成する操作です。このフィルターは、畳み込み層で学習されるパラメータであり、画像やテキストなどの特徴を抽出する役割を果たします。畳み込みは、入力データ全体に対してフィルターをスライドさせながら演算を行い、特徴マップを生成します。

プーリングの役割

プーリングは、畳み込み層で得られた特徴マップを縮小するための操作です。一般的には、最大プーリングや平均プーリングなどが使われます。プーリングによって特徴マップのサイズが縮小され、計算量が削減されると同時に、位置の微小な変化に対するロバスト性が向上します。

活性化関数の重要性

活性化関数は、ニューラルネットワークの非線形性を導入するために使用されます。代表的な活性化関数にはReLUやSigmoid、Tanhなどがあります。適切な活性化関数の選択は、ネットワークの表現力や学習の収束速度に大きな影響を与えます。活性化関数を通じて、ネットワークは非線形な特徴を学習し、複雑な関係性を捉えることが可能となります。

畳み込みニューラルネットワークの応用

画像認識への応用

畳み込みニューラルネットワークは、画像認識において驚異的な成果を上げています。画像認識では、畳み込み層を用いて画像の特徴を抽出し、プーリング層で特徴を縮小していきます。これにより、ネットワークは画像内のパターンや物体を識別することが可能となります。例えば、犬や猫などの動物を識別するために畳み込みニューラルネットワークが広く活用されています。

自然言語処理への応用

自然言語処理では、畳み込みニューラルネットワークがテキストデータの解析や処理に活用されています。テキストデータは一次元のデータであるため、畳み込み層を用いて単語や文の特徴を抽出し、その後の層で意味の理解や文脈の把握を行います。自然言語処理においても、畳み込みニューラルネットワークは高い性能を発揮し、機械翻訳や感情分析などのタスクに応用されています。

医用画像解析への応用

医用画像解析では、畳み込みニューラルネットワークが診断支援や病変検出などに活用されています。医用画像は高次元かつ複雑なデータであるため、畳み込みニューラルネットワークがその特徴を的確に捉えることができます。異常検知や疾患の診断支援において、畳み込みニューラルネットワークは医療現場で重要な役割を果たしています。

畳み込みニューラルネットワークの学習方法

バックプロパゲーションの原理

バックプロパゲーションは、ニューラルネットワークの学習において重要な原理です。この手法では、出力と正解ラベルの誤差を逆伝播させることで、各層の重みを更新していきます。具体的には、誤差逆伝播法を用いて、各層の重みの勾配を計算し、最適化アルゴリズムによって重みを更新します。バックプロパゲーションを通じて、ニューラルネットワークは訓練データに適合するように学習していきます。

最適化アルゴリズムの選択

ニューラルネットワークの学習において、最適化アルゴリズムの選択は重要です。最適化アルゴリズムは、誤差関数を最小化するために重みを更新する手法です。代表的な最適化アルゴリズムには、確率的勾配降下法(SGD)、Adam、RMSpropなどがあります。これらのアルゴリズムは、学習率やモーメンタムなどのハイパーパラメータを調整することで、ニューラルネットワークの学習を効率化する役割を果たします。

畳み込みニューラルネットワークの評価指標

精度の評価方法

畳み込みニューラルネットワークの評価指標の一つに「精度」があります。精度は、モデルが正しく予測したデータの割合を示す指標であり、正解率とも呼ばれます。モデルが与えられたデータに対してどれだけ正確に予測できるかを示すため、高い精度を持つモデルほど信頼性が高いと言えます。

精度は以下の式で計算されます。精度 = (正しく分類されたサンプル数) / (全サンプル数)です。この値が1に近いほど、モデルの性能が高いと言えます。精度を向上させるためには、適切な学習データの準備やハイパーパラメータの調整などが重要です。

適合率と再現率のバランス

畳み込みニューラルネットワークの評価指標には、「適合率」と「再現率」のバランスも重要です。適合率は、モデルが陽性と予測したデータのうち実際に陽性である割合を示し、再現率は実際に陽性であるデータのうちモデルが正しく陽性と予測した割合を示します。

適合率と再現率はトレードオフの関係にあり、一方を向上させるともう一方が低下する傾向があります。適合率と再現率のバランスを考慮しながらモデルを評価することで、より信頼性の高い評価が可能となります。

転移学習の活用

転移学習の定義

転移学習は、あるタスクで学習された知識やモデルを別の関連するタスクに適用する手法です。通常、大規模なデータセットで事前に学習されたモデルを、新しいタスクに適用して学習を効率化することが可能となります。転移学習は、少ないデータで高い性能を実現するために有用な手法として広く利用されています。

転移学習の利点

転移学習にはいくつかの利点があります。まず、事前に学習されたモデルを使用することで、新しいタスクにおいて学習に必要なデータ量を削減することができます。これにより、学習時間やリソースの節約が可能となります。また、転移学習は既存の知識を活用するため、新しいタスクにおいてより高い性能を実現することが期待されます。

畳み込みニューラルネットワークの最適化手法

学習率の調整

ニューラルネットワークの学習において、学習率の調整は非常に重要です。学習率は、重みの更新量を決定するパラメータであり、適切な学習率を設定することで、モデルの収束速度や性能を向上させることができます。

学習率が大きすぎると、収束せずに発散してしまう可能性があります。一方、学習率が小さすぎると、収束までに時間がかかるだけでなく、局所最適解に収束してしまうリスクもあります。適切な学習率を見つけるためには、ハイパーパラメータチューニングや学習曲線の分析が必要です。

正則化の重要性

正則化は、過学習を防ぐための重要な手法です。過学習は、モデルが訓練データに過度に適合し、未知のデータに対する汎化性能が低下する現象です。正則化は、モデルの複雑さを制御することで、過学習を抑制し、汎化性能を向上させる役割を果たします。

代表的な正則化手法には、L1正則化やL2正則化があります。これらの手法は、損失関数に正則化項を追加することで、重みの大きさを制約し、過学習を防ぐ効果があります。正則化を適切に適用することで、モデルの汎化性能を向上させることができます。

まとめ

畳み込みニューラルネットワーク(CNN)は、画像認識や自然言語処理などの様々な分野で活用されています。本記事では、CNNの基礎から応用までを詳しく解説しました。畳み込みやプーリングといった操作、活性化関数の選択、最適化アルゴリズムの重要性などについて理解を深めました。さらに、画像認識、自然言語処理、医用画像解析などでのCNNの応用についても紹介しました。バックプロパゲーションや最適化アルゴリズム、評価指標など、CNNの学習方法や評価についても理解を深めました。転移学習や最適化手法についても触れ、CNNの効果的な活用法について学びました。CNNの基礎から応用までを網羅し、畳み込みニューラルネットワークの理解を深めることができました。

コメント